NVIDIAは、大規模言語モデル(LLM)向けの新しいメモリーアーキテクチャ「MemoryX」を発表しました。MemoryXは最大384GBを搭載し、従来のGPUやAIプロセッサーに比べて大幅なスケーラビリティを実現します。

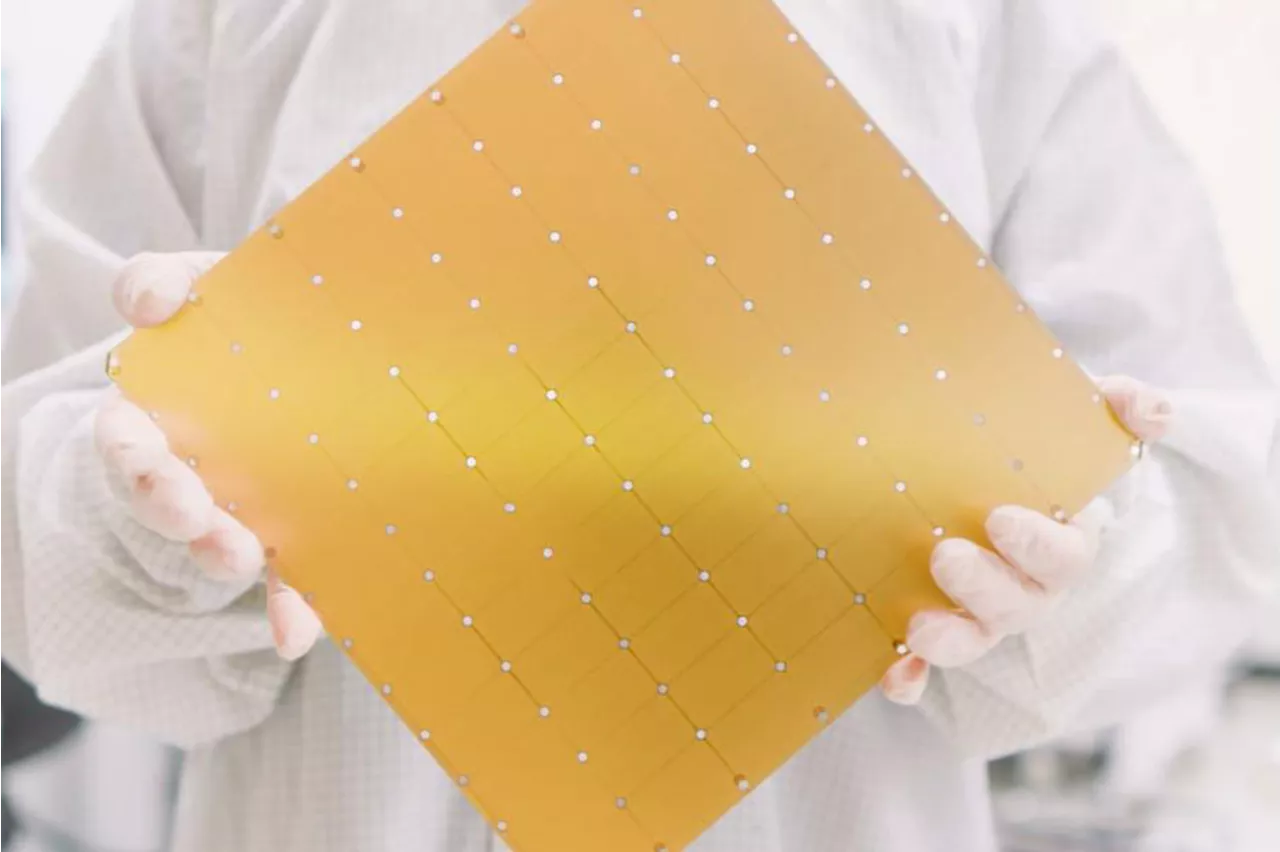

そもそも NVIDIA のA100ですら40GB版に加えて80GB版をリリース。H200は141GB、GB200ではHBMだけで384GBを搭載する。AMDもInstinct MI300Xで192GBを搭載したが、次のInstinct MI325Xでは288GBに増量することを発表している。 LLM の規模がどんどん大きくなることでメモリー不足になるのは明白である。このMemoryXを併用する場合、重みデータはすべてMemoryXに置かれる形になり、アクティベーションのみがWSE-2のSRAMに格納される形になる。またこの重みのアップデートはMemoryX内のプロセッサーで行なうため、WSE-2には負荷をかけずにできるとする。

2つ上の画像で"Execute one layer at a time"という言い方をしているあたり、ネットワークのある層を複数のWSE-2で分割して処理する形であり、その際にMemoryXはSwarmX経由で、その層の重みを対象のWSE-2にブロードキャストするようだ。

AI NVIDIA Memoryx LLM AI Scale

日本 最新ニュース, 日本 見出し

Similar News:他のニュース ソースから収集した、これに似たニュース記事を読むこともできます。

NVIDIA、HBM搭載メモリカード「MemoryX」と通信チップ「SwarmX」を発表Nvidiaは、大規模AIモデルの訓練に特化した新しいメモリカード「MemoryX」と通信チップ「SwarmX」を発表しました。従来のGPUやAIプロセッサーでは発生するメモリー不足の問題を解決し、WSE-2処理ユニットが効率的に動作できるように設計されています。

NVIDIA、HBM搭載メモリカード「MemoryX」と通信チップ「SwarmX」を発表Nvidiaは、大規模AIモデルの訓練に特化した新しいメモリカード「MemoryX」と通信チップ「SwarmX」を発表しました。従来のGPUやAIプロセッサーでは発生するメモリー不足の問題を解決し、WSE-2処理ユニットが効率的に動作できるように設計されています。

続きを読む »

NVIDIA、MemoryXとSwarmXで巨大AIモデルのメモリ不足を解決NVIDIAは、大規模言語モデル(LLM)のメモリー不足問題を解決するために、新しいメモリーアーキテクチャ「MemoryX」と通信ネットワーク「SwarmX」を発表した。これにより、膨大な重みデータを集中管理し、WSE-2プロセッサーに高速でアクセスできるようにすることで、大規模モデルの学習と実行性能を向上させる。

NVIDIA、MemoryXとSwarmXで巨大AIモデルのメモリ不足を解決NVIDIAは、大規模言語モデル(LLM)のメモリー不足問題を解決するために、新しいメモリーアーキテクチャ「MemoryX」と通信ネットワーク「SwarmX」を発表した。これにより、膨大な重みデータを集中管理し、WSE-2プロセッサーに高速でアクセスできるようにすることで、大規模モデルの学習と実行性能を向上させる。

続きを読む »

Cloudera 、生成 AI の開発とデプロイメントを加速する組み込み型 NVIDIA NIM マイクロサービスを搭載したAI 推論サービスおよび、新機能を発表Cloudera 、生成 AI の開発とデプロイメントを加速する組み込み型 NVIDIA NIM マイクロサービスを搭載したAI 推論サービスおよび、新機能を発表 Cloudera株式会社のプレスリリース

Cloudera 、生成 AI の開発とデプロイメントを加速する組み込み型 NVIDIA NIM マイクロサービスを搭載したAI 推論サービスおよび、新機能を発表Cloudera 、生成 AI の開発とデプロイメントを加速する組み込み型 NVIDIA NIM マイクロサービスを搭載したAI 推論サービスおよび、新機能を発表 Cloudera株式会社のプレスリリース

続きを読む »

米国の大手テクノロジ企業が NVIDIA AI ソフトウェアを活用し、世界の産業を変革米国の大手テクノロジ企業が NVIDIA AI ソフトウェアを活用し、世界の産業を変革 NVIDIAのプレスリリース

米国の大手テクノロジ企業が NVIDIA AI ソフトウェアを活用し、世界の産業を変革米国の大手テクノロジ企業が NVIDIA AI ソフトウェアを活用し、世界の産業を変革 NVIDIAのプレスリリース

続きを読む »

GMOインターネットグループ、「NVIDIA H200 GPU」搭載環境の性能を実証GMOインターネットグループ、「NVIDIA H200 GPU」搭載環境の性能を実証 GMOインターネットグループのプレスリリース

GMOインターネットグループ、「NVIDIA H200 GPU」搭載環境の性能を実証GMOインターネットグループ、「NVIDIA H200 GPU」搭載環境の性能を実証 GMOインターネットグループのプレスリリース

続きを読む »

NetApp、NVIDIA との提携によりエンタープライズ RAG を再定義して エージェント型AI を強化NetApp、NVIDIA との提携によりエンタープライズ RAG を再定義して エージェント型AI を強化 ネットアップ合同会社のプレスリリース

NetApp、NVIDIA との提携によりエンタープライズ RAG を再定義して エージェント型AI を強化NetApp、NVIDIA との提携によりエンタープライズ RAG を再定義して エージェント型AI を強化 ネットアップ合同会社のプレスリリース

続きを読む »